C# Lang MCP Server

一个 VS Code 扩展提供了一个 MCP 服务器,该服务器暴露 Roslyn 语言特性。它支持诸如查找用法、转到定义、快速信息等工具。

README

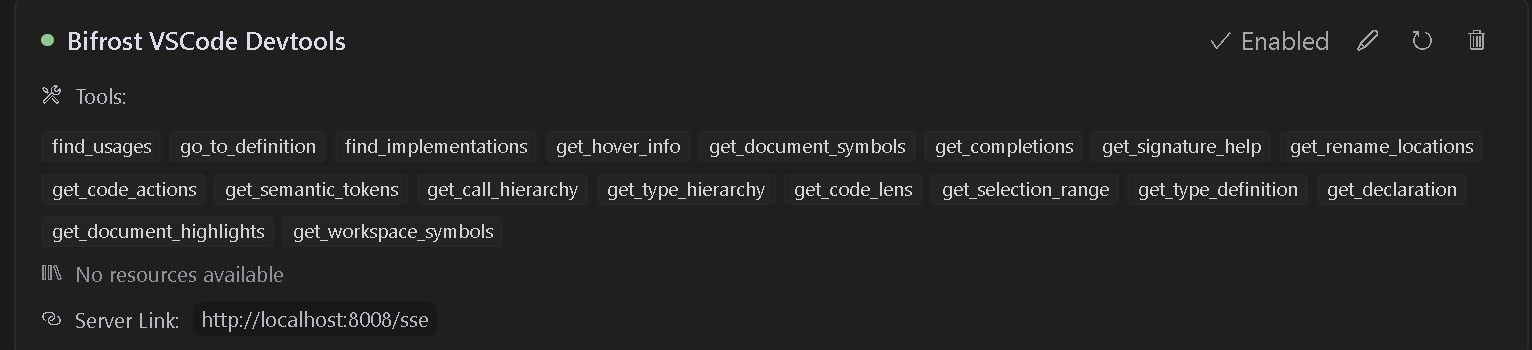

Bifrost - VSCode 开发工具 MCP 服务器

<a href="https://marketplace.visualstudio.com/items?itemName=ConnorHallman.bifrost-mcp"> <img src="https://img.shields.io/visual-studio-marketplace/d/ConnorHallman.bifrost-mcp?label=VSCode%20Extension%20Downloads&cacheSeconds=3600" alt="VSCode Extension Downloads" width="250"> </a>

此 VS Code 扩展提供了一个模型上下文协议 (MCP) 服务器,该服务器将 VSCode 强大的开发工具和语言功能暴露给 AI 工具。当使用支持 MCP 协议的 AI 编码助手时,它可以实现高级代码导航、分析和操作功能。

功能

- 语言服务器集成:访问 VSCode 语言服务器对任何支持的语言的功能

- 代码导航:查找引用、定义、实现等

- 符号搜索:在您的工作区中搜索符号

- 代码分析:获取语义标记、文档符号和类型信息

- 智能选择:使用语义选择范围进行智能代码选择

- 代码操作:访问重构建议和快速修复

- HTTP/SSE 服务器:通过 MCP 兼容的 HTTP 服务器公开语言功能

- AI 助手集成:准备好与支持 MCP 协议的 AI 助手一起工作

用法

Cline 安装

- 步骤 1. 安装 Supergateway

- 步骤 2. 将配置添加到 cline

- 步骤 3. 它会显示为红色,但似乎工作正常

{

"mcpServers": {

"Bifrost": {

"command": "cmd",

"args": [

"/c",

"npx",

"-y",

"supergateway",

"--sse",

"http://localhost:8008/sse"

],

"disabled": false,

"autoApprove": [],

"timeout": 600

}

}

}

按照此视频进行安装并与 cursor 一起使用。我还提供了可以在 .cursorrules 文件中使用的示例规则,以获得更好的结果。

对于新版本的 CURSOR,请使用此代码

{

"mcpServers": {

"Bifrost": {

"url": "http://localhost:8008/sse"

}

}

}

多项目支持

当处理多个项目时,每个项目都可以有自己专用的 MCP 服务器端点和端口。当您打开多个 VS Code 窗口或处理需要语言服务器功能的多个项目时,这非常有用。

项目配置

在您的项目根目录中创建一个 bifrost.config.json 文件:

{

"projectName": "MyProject",

"description": "您的项目描述",

"path": "/my-project",

"port": 5642

}

服务器将使用此配置来:

- 创建特定于项目的端点(例如,

http://localhost:5642/my-project/sse) - 向 AI 助手提供项目信息

- 为每个项目使用专用端口

- 将项目服务与其他运行实例隔离

示例配置

- 后端 API 项目:

{

"projectName": "BackendAPI",

"description": "带有 TypeScript 的 Node.js REST API",

"path": "/backend-api",

"port": 5643

}

- 前端 Web 应用程序:

{

"projectName": "FrontendApp",

"description": "React 前端应用程序",

"path": "/frontend-app",

"port": 5644

}

端口配置

每个项目都应指定其自己唯一的端口,以避免在运行多个 VS Code 实例时发生冲突:

bifrost.config.json中的port字段确定服务器将使用的端口- 如果未指定端口,则默认为 8008 以实现向后兼容

- 为不同的项目选择不同的端口,以确保它们可以同时运行

- 如果配置的端口已被使用,服务器将无法启动,需要您:

- 释放端口

- 更改配置中的端口

- 关闭使用该端口的其他 VS Code 实例

连接到特定于项目的端点

更新您的 AI 助手配置以使用特定于项目的端点和端口:

{

"mcpServers": {

"BackendAPI": {

"url": "http://localhost:5643/backend-api/sse"

},

"FrontendApp": {

"url": "http://localhost:5644/frontend-app/sse"

}

}

}

向后兼容性

如果不存在 bifrost.config.json,服务器将使用默认配置:

- 端口:8008

- SSE 端点:

http://localhost:8008/sse - 消息端点:

http://localhost:8008/message

这保持了与现有配置和工具的兼容性。

可用工具

该扩展提供了对许多 VSCode 语言功能的访问,包括:

- find_usages: 查找所有符号引用。

- go_to_definition: 立即跳转到符号定义。

- find_implementations: 发现接口/抽象方法的实现。

- get_hover_info: 获取悬停时丰富的符号文档。

- get_document_symbols: 概述文件中的所有符号。

- get_completions: 上下文相关的自动完成。

- get_signature_help: 函数参数提示和重载。

- get_rename_locations: 安全地重命名项目中的符号。

- get_code_actions: 快速修复、重构和改进。

- get_semantic_tokens: 增强的突出显示数据。

- get_call_hierarchy: 查看传入/传出调用关系。

- get_type_hierarchy: 可视化类和接口继承。

- get_code_lens: 内联见解(引用、测试等)。

- get_selection_range: 用于代码块的智能选择扩展。

- get_type_definition: 跳转到基础类型定义。

- get_declaration: 导航到符号声明。

- get_document_highlights: 突出显示符号的所有出现位置。

- get_workspace_symbols: 在整个工作区中搜索符号。

要求

- Visual Studio Code 版本 1.93.0 或更高版本

- 适用于您要使用的语言的相应语言扩展(例如,C# 文件的 C# 扩展)

安装

- 从 VS Code 市场安装此扩展

- 安装您开发所需的任何特定于语言的扩展

- 在 VS Code 中打开您的项目

用法

该扩展将在激活时自动启动 MCP 服务器。要配置 AI 助手以使用此服务器:

- 服务器默认在端口 8008 上运行

- 配置您的 MCP 兼容 AI 助手以连接到:

- SSE 端点:

http://localhost:8008/sse - 消息端点:

http://localhost:8008/message

- SSE 端点:

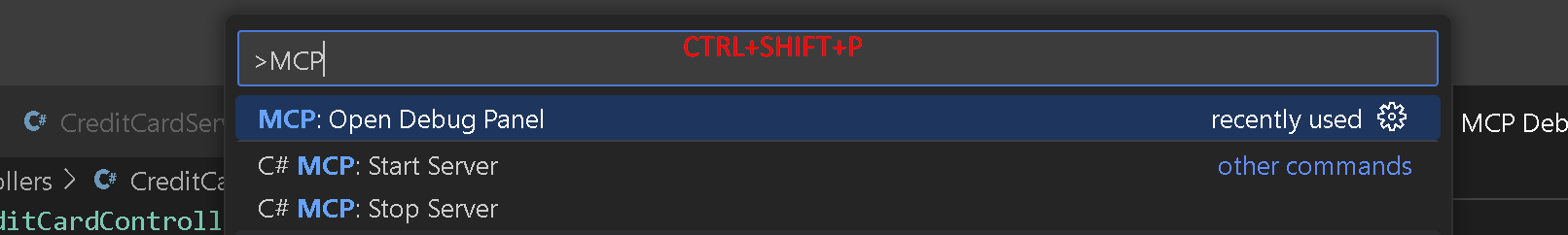

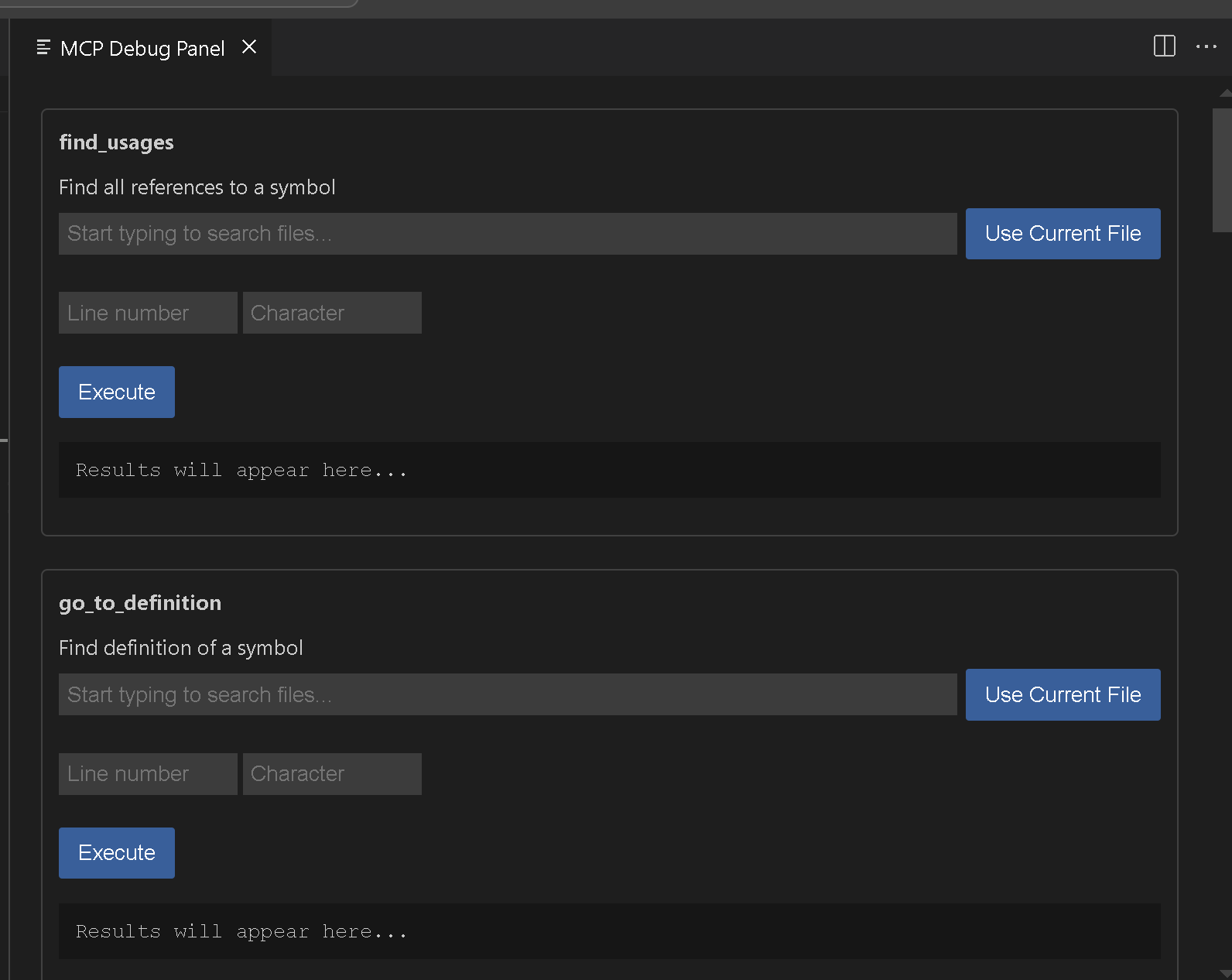

可用命令

Bifrost MCP: 启动服务器- 手动在端口 8008 上启动 MCP 服务器Bifrost MCP: 在端口上启动服务器- 手动在指定端口上启动 MCP 服务器Bifrost MCP: 停止服务器- 停止正在运行的 MCP 服务器Bifrost MCP: 打开调试面板- 打开调试面板以测试可用工具

示例工具用法

查找引用

{

"name": "find_usages",

"arguments": {

"textDocument": {

"uri": "file:///path/to/your/file"

},

"position": {

"line": 10,

"character": 15

},

"context": {

"includeDeclaration": true

}

}

}

工作区符号搜索

{

"name": "get_workspace_symbols",

"arguments": {

"query": "MyClass"

}

}

调试

使用 MCP: 打开调试面板 命令

故障排除

如果您遇到问题:

- 确保您已为您的项目安装了相应的语言扩展

- 检查您的项目是否已在 VSCode 中正确加载

- 验证端口 8008 在您的系统上是否可用

- 检查 VSCode 输出面板中是否有任何错误消息

贡献

如果您想添加其他功能,请参阅 Vscodes 命令。我认为我们仍然需要重命名和其他一些功能。 请随时提交问题或拉取请求到 GitHub 存储库。

许可证

此扩展在 APGL-3.0 许可证下获得许可。

推荐服务器

Playwright MCP Server

一个模型上下文协议服务器,它使大型语言模型能够通过结构化的可访问性快照与网页进行交互,而无需视觉模型或屏幕截图。

e2b-mcp-server

使用 MCP 通过 e2b 运行代码。

Neon MCP Server

用于与 Neon 管理 API 和数据库交互的 MCP 服务器

Exa MCP Server

模型上下文协议(MCP)服务器允许像 Claude 这样的 AI 助手使用 Exa AI 搜索 API 进行网络搜索。这种设置允许 AI 模型以安全和受控的方式获取实时的网络信息。

mcp-server-qdrant

这个仓库展示了如何为向量搜索引擎 Qdrant 创建一个 MCP (Managed Control Plane) 服务器的示例。

AIO-MCP Server

🚀 集成了 AI 搜索、RAG 和多服务(GitLab/Jira/Confluence/YouTube)的一体化 MCP 服务器,旨在增强 AI 驱动的开发工作流程。来自 Folk。

Knowledge Graph Memory Server

为 Claude 实现持久性记忆,使用本地知识图谱,允许 AI 记住用户的信息,并可在自定义位置存储,跨对话保持记忆。

Hyperbrowser

欢迎来到 Hyperbrowser,人工智能的互联网。Hyperbrowser 是下一代平台,旨在增强人工智能代理的能力,并实现轻松、可扩展的浏览器自动化。它专为人工智能开发者打造,消除了本地基础设施和性能瓶颈带来的麻烦,让您能够:

https://github.com/Streen9/react-mcp

react-mcp 与 Claude Desktop 集成,能够根据用户提示创建和修改 React 应用程序。

MCP Atlassian

适用于 Atlassian Cloud 产品(Confluence 和 Jira)的 Model Context Protocol (MCP) 服务器。此集成专为 Atlassian Cloud 实例设计,不支持 Atlassian Server 或 Data Center 部署。