TxtAI MCP Server

txtai 是一个一体化的嵌入数据库,用于语义搜索、LLM 编排和语言模型工作流程。所有功能都可以通过其 API 提供,并且该 API 支持 MCP。 文档:https://neuml.github.io/txtai/api/mcp/

README

<p align="center"> <b>一体化嵌入数据库</b> </p>

<p align="center"> <a href="https://github.com/neuml/txtai/releases"> <img src="https://img.shields.io/github/release/neuml/txtai.svg?style=flat&color=success" alt="Version"/> </a> <a href="https://github.com/neuml/txtai"> <img src="https://img.shields.io/github/last-commit/neuml/txtai.svg?style=flat&color=blue" alt="GitHub last commit"/> </a> <a href="https://github.com/neuml/txtai/issues"> <img src="https://img.shields.io/github/issues/neuml/txtai.svg?style=flat&color=success" alt="GitHub issues"/> </a> <a href="https://join.slack.com/t/txtai/shared_invite/zt-1cagya4yf-DQeuZbd~aMwH5pckBU4vPg"> <img src="https://img.shields.io/badge/slack-join-blue?style=flat&logo=slack&logocolor=white" alt="Join Slack"/> </a> <a href="https://github.com/neuml/txtai/actions?query=workflow%3Abuild"> <img src="https://github.com/neuml/txtai/workflows/build/badge.svg" alt="Build Status"/> </a> <a href="https://coveralls.io/github/neuml/txtai?branch=master"> <img src="https://img.shields.io/coverallsCoverage/github/neuml/txtai" alt="Coverage Status"> </a> </p>

txtai 是一个一体化嵌入数据库,用于语义搜索、LLM 编排和语言模型工作流程。

嵌入数据库是向量索引(稀疏和密集)、图网络和关系数据库的结合。

这个基础支持向量搜索,并且/或者作为大型语言模型 (LLM) 应用程序的强大知识来源。

构建自主代理、检索增强生成 (RAG) 流程、多模型工作流程等等。

txtai 功能摘要:

- 🔎 具有 SQL、对象存储、主题建模、图分析和多模态索引的向量搜索

- 📄 为文本、文档、音频、图像和视频创建嵌入

- 💡 由语言模型驱动的管道,运行 LLM 提示、问答、标记、转录、翻译、摘要等

- ↪️️ 将管道连接在一起并聚合业务逻辑的工作流程。txtai 进程可以是简单的微服务或多模型工作流程。

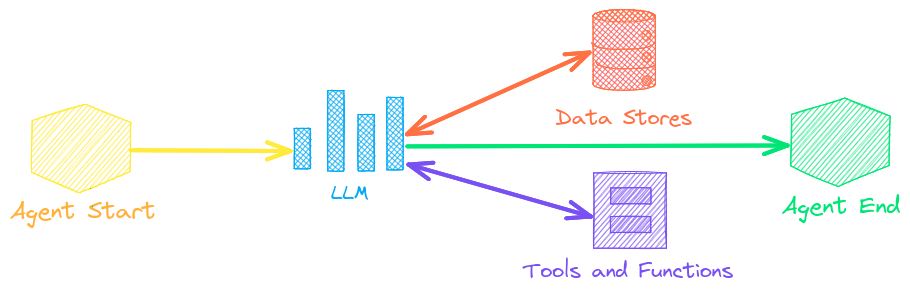

- 🤖 将嵌入、管道、工作流程和其他代理智能连接在一起以自主解决复杂问题的代理

- ⚙️ Web 和模型上下文协议 (MCP) API。JavaScript、Java、Rust 和 Go 的绑定可用。

- 🔋 包含默认设置,可快速启动和运行

- ☁️ 在本地运行或使用容器编排进行扩展

txtai 使用 Python 3.10+、Hugging Face Transformers、Sentence Transformers 和 FastAPI 构建。txtai 在 Apache 2.0 许可下开源。

有兴趣以简单安全的方式运行托管的 txtai 应用程序吗?然后加入 txtai.cloud 预览版以了解更多信息。

为什么选择 txtai?

新的向量数据库、LLM 框架以及介于两者之间的所有内容每天都在涌现。为什么要使用 txtai 构建?

# 在几行代码中开始

import txtai

embeddings = txtai.Embeddings()

embeddings.index(["Correct", "Not what we hoped"])

embeddings.search("positive", 1)

#[(0, 0.29862046241760254)]

- 内置 API 使使用您选择的编程语言开发应用程序变得容易

# app.yml

embeddings:

path: sentence-transformers/all-MiniLM-L6-v2

CONFIG=app.yml uvicorn "txtai.api:app"

curl -X GET "http://localhost:8000/search?query=positive"

- 在本地运行 - 无需将数据发送到不同的远程服务

- 使用从微模型到大型语言模型 (LLM) 的所有模型

- 低占用空间 - 在需要时安装其他依赖项并进行扩展

- 通过示例学习 - 笔记本涵盖所有可用功能

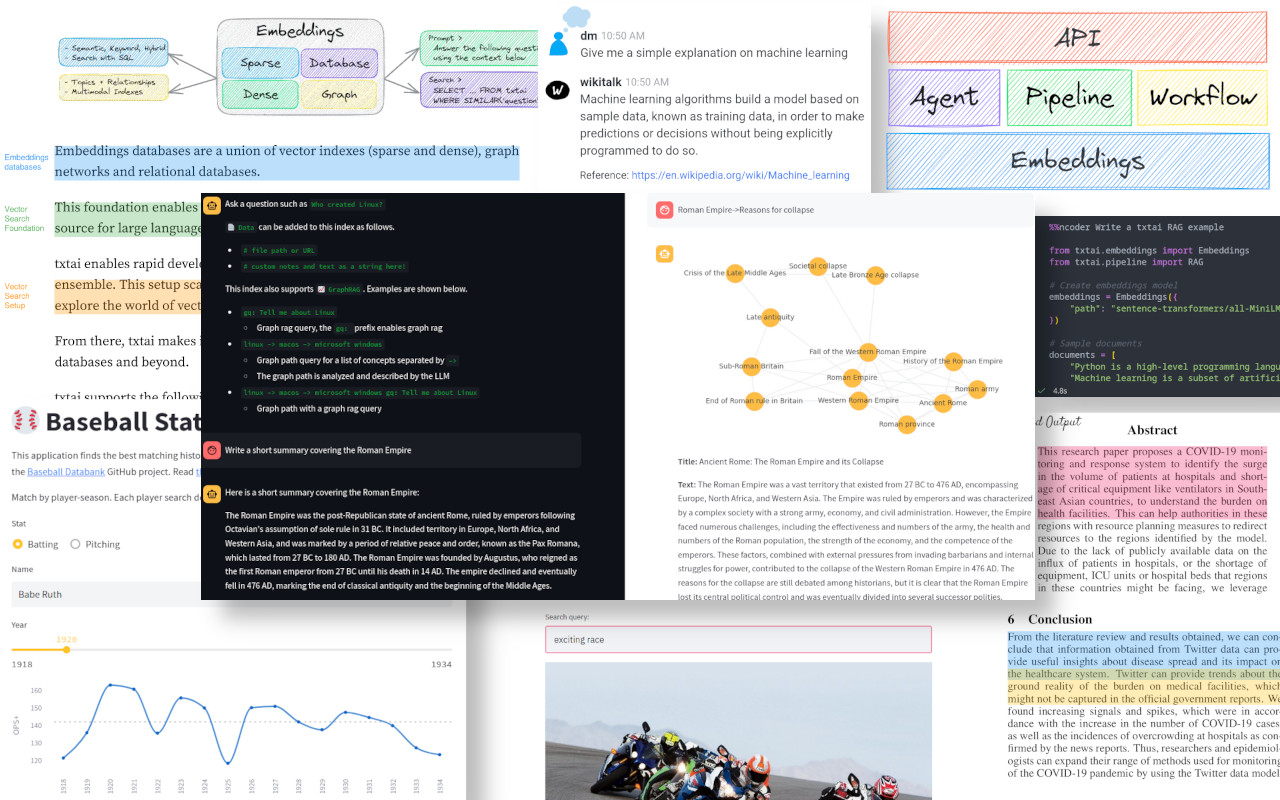

用例

以下部分介绍常见的 txtai 用例。还提供了一套包含 60 多个示例笔记本和应用程序的综合集合。

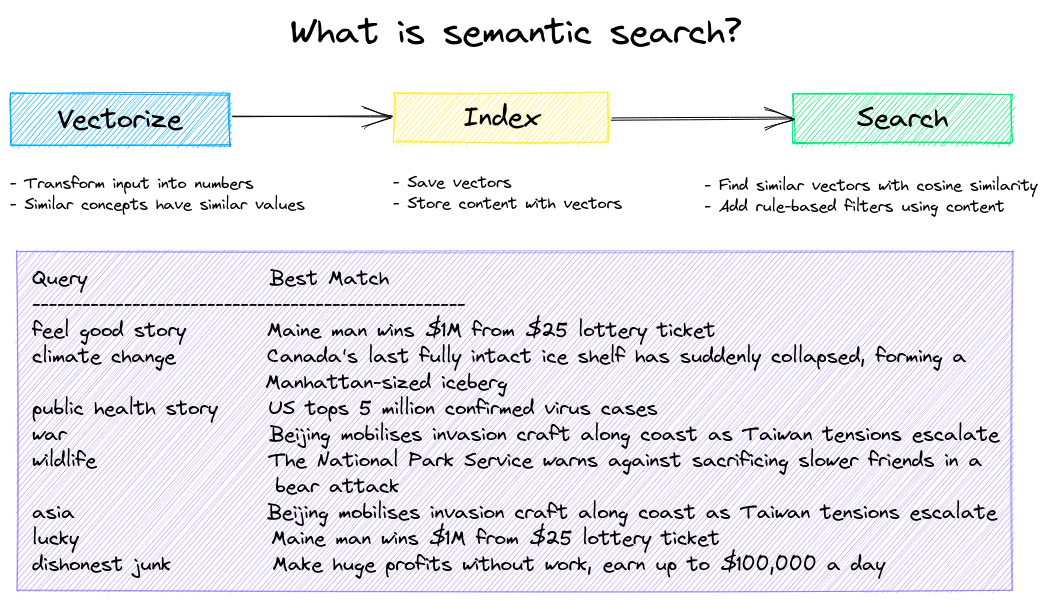

语义搜索

构建语义/相似性/向量/神经搜索应用程序。

传统的搜索系统使用关键字来查找数据。语义搜索了解自然语言,并识别具有相同含义的结果,而不一定是相同的关键字。

从以下示例开始。

| 笔记本 | 描述 | |

|---|---|---|

| Introducing txtai ▶️ | txtai 提供的功能概述 | |

| Similarity search with images | 将图像和文本嵌入到同一空间以进行搜索 | |

| Build a QA database | 使用语义搜索进行问题匹配 | |

| Semantic Graphs | 探索主题、数据连接并运行网络分析 |

LLM 编排

自主代理、检索增强生成 (RAG)、与您的数据聊天、与大型语言模型 (LLM) 交互的管道和工作流程。

请参阅下文以了解更多信息。

| 笔记本 | 描述 | |

|---|---|---|

| Prompt templates and task chains | 构建模型提示并将任务与工作流程连接在一起 | |

| Integrate LLM frameworks | 集成 llama.cpp、LiteLLM 和自定义生成框架 | |

| Build knowledge graphs with LLMs | 使用 LLM 驱动的实体提取构建知识图 | |

| Parsing the stars with txtai | 探索已知恒星、行星、星系的星体知识图 |

代理

代理将嵌入、管道、工作流程和其他代理连接在一起,以自主解决复杂问题。

txtai 代理构建在 Transformers Agent 框架之上。这支持 txtai 支持的所有 LLM(Hugging Face、llama.cpp、OpenAI / Claude / AWS Bedrock 通过 LiteLLM)。

请参阅下面的链接以了解更多信息。

| 笔记本 | 描述 | |

|---|---|---|

| Analyzing Hugging Face Posts with Graphs and Agents | 使用图分析和代理探索丰富的数据集 | |

| Granting autonomy to agents | 代理可以根据自己的判断迭代地解决问题 | |

| Analyzing LinkedIn Company Posts with Graphs and Agents | 探索如何使用 AI 改善社交媒体参与度 |

检索增强生成

检索增强生成 (RAG) 通过使用知识库作为上下文来约束输出来降低 LLM 幻觉的风险。RAG 通常用于“与您的数据聊天”。

txtai 的一个新颖功能是它可以同时提供答案和来源引用。

| 笔记本 | 描述 | |

|---|---|---|

| Build RAG pipelines with txtai | 检索增强生成指南,包括如何创建引用 | |

| Chunking your data for RAG | 提取、分块和索引内容以进行有效检索 | |

| Advanced RAG with graph path traversal | 图路径遍历以收集复杂的数据集以进行高级 RAG | |

| Speech to Speech RAG ▶️ | 具有 RAG 的全周期语音到语音工作流程 |

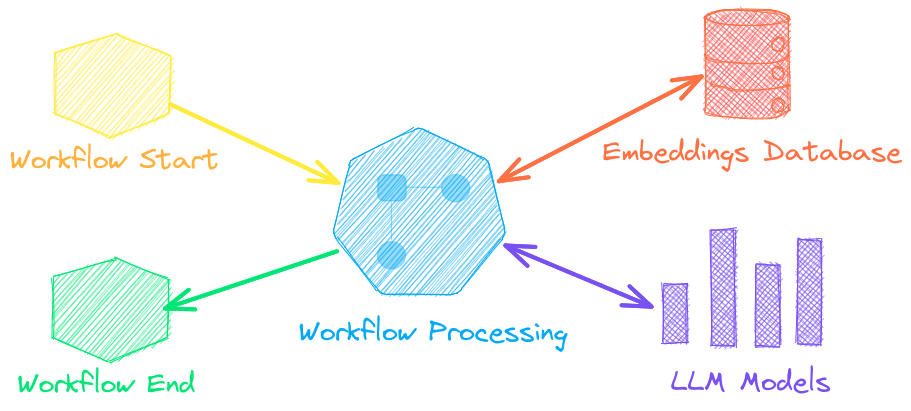

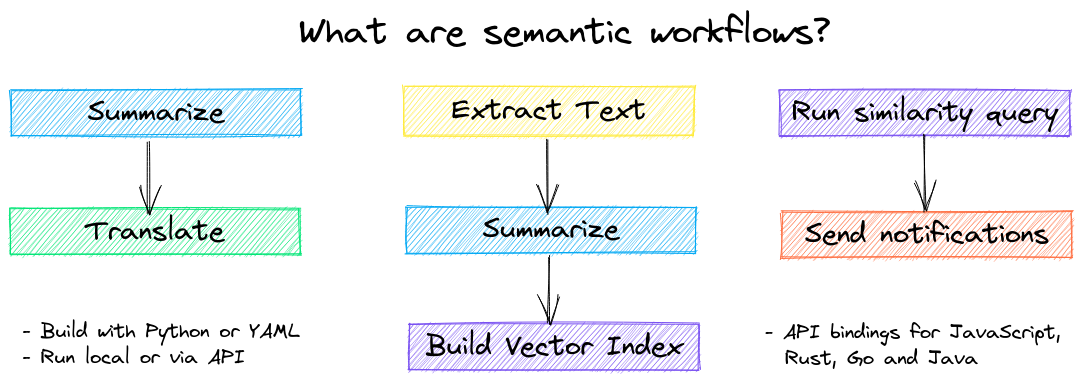

语言模型工作流程

语言模型工作流程,也称为语义工作流程,将语言模型连接在一起以构建智能应用程序。

虽然 LLM 功能强大,但对于特定任务,有许多更小、更专业的模型可以更好、更快地工作。这包括用于提取式问答、自动摘要、文本到语音、转录和翻译的模型。

| 笔记本 | 描述 | |

|---|---|---|

| Run pipeline workflows ▶️ | 简单而强大的结构,可有效处理数据 | |

| Building abstractive text summaries | 运行抽象文本摘要 | |

| Transcribe audio to text | 将音频文件转换为文本 | |

| Translate text between languages | 简化机器翻译和语言检测 |

安装

最简单的安装方法是通过 pip 和 PyPI

pip install txtai

支持 Python 3.10+。建议使用 Python 虚拟环境。

有关更多信息,请参阅详细的安装说明,其中涵盖可选依赖项、特定于环境的先决条件、从源代码安装、conda 支持 以及如何使用容器运行。

模型指南

请参阅下表,了解当前推荐的模型。这些模型都允许商业用途,并提供速度和性能的结合。

| 组件 | 模型 |

|---|---|

| 嵌入 | all-MiniLM-L6-v2 |

| 图像标题 | BLIP |

| 标签 - 零样本 | BART-Large-MNLI |

| 标签 - 固定 | 使用训练管道进行微调 |

| 大型语言模型 (LLM) | Llama 3.1 Instruct |

| 摘要 | DistilBART |

| 文本到语音 | ESPnet JETS |

| 转录 | Whisper |

| 翻译 | OPUS 模型系列 |

模型可以作为 Hugging Face Hub 中的路径或本地目录加载。模型路径是可选的,未指定时加载默认值。对于没有推荐模型的任务,txtai 使用 Hugging Face Tasks 指南中显示的默认模型。

请参阅以下链接以了解更多信息。

- Hugging Face Tasks

- Hugging Face Model Hub

- MTEB Leaderboard

- LMSYS LLM Leaderboard

- Open LLM Leaderboard

由 txtai 驱动

以下应用程序由 txtai 驱动。

| 应用程序 | 描述 |

|---|---|

| rag | 检索增强生成 (RAG) 应用程序 |

| ragdata | 为 RAG 构建知识库 |

| paperai | 用于医学/科学论文的语义搜索和工作流程 |

| annotateai | 使用 LLM 自动注释论文 |

除了此列表之外,还有许多其他开源项目、已发表的研究 和封闭的专有/商业项目已在生产中基于 txtai 构建。

延伸阅读

- Introducing txtai, the all-in-one embeddings database

- Tutorial series on Hashnode | dev.to

- What's new in txtai 8.0 | 7.0 | 6.0 | 5.0 | 4.0

- Getting started with semantic search | workflows | rag

- Running txtai at scale

- Vector search & RAG Landscape: A review with txtai

文档

txtai 上的完整文档,包括嵌入、管道、工作流程、API 的配置设置以及包含常见问题/问题的 FAQ,均可用。

贡献

对于那些想要为 txtai 做出贡献的人,请参阅本指南。

推荐服务器

Baidu Map

百度地图核心API现已全面兼容MCP协议,是国内首家兼容MCP协议的地图服务商。

Playwright MCP Server

一个模型上下文协议服务器,它使大型语言模型能够通过结构化的可访问性快照与网页进行交互,而无需视觉模型或屏幕截图。

Magic Component Platform (MCP)

一个由人工智能驱动的工具,可以从自然语言描述生成现代化的用户界面组件,并与流行的集成开发环境(IDE)集成,从而简化用户界面开发流程。

Audiense Insights MCP Server

通过模型上下文协议启用与 Audiense Insights 账户的交互,从而促进营销洞察和受众数据的提取和分析,包括人口统计信息、行为和影响者互动。

VeyraX

一个单一的 MCP 工具,连接你所有喜爱的工具:Gmail、日历以及其他 40 多个工具。

graphlit-mcp-server

模型上下文协议 (MCP) 服务器实现了 MCP 客户端与 Graphlit 服务之间的集成。 除了网络爬取之外,还可以将任何内容(从 Slack 到 Gmail 再到播客订阅源)导入到 Graphlit 项目中,然后从 MCP 客户端检索相关内容。

Kagi MCP Server

一个 MCP 服务器,集成了 Kagi 搜索功能和 Claude AI,使 Claude 能够在回答需要最新信息的问题时执行实时网络搜索。

e2b-mcp-server

使用 MCP 通过 e2b 运行代码。

Neon MCP Server

用于与 Neon 管理 API 和数据库交互的 MCP 服务器

Exa MCP Server

模型上下文协议(MCP)服务器允许像 Claude 这样的 AI 助手使用 Exa AI 搜索 API 进行网络搜索。这种设置允许 AI 模型以安全和受控的方式获取实时的网络信息。