Multi-Model Advisor

决策模型委员会 / 决策模型理事会

YuChenSSR

Tools

list-available-models

List all available models in Ollama that can be used with query-models

query-models

Query multiple AI models via Ollama and get their responses to compare perspectives

README

多模型顾问

(锵锵四人行)

一个模型上下文协议 (MCP) 服务器,它查询多个 Ollama 模型并结合它们的响应,从而为单个问题提供多样化的人工智能视角。 这创建了一种“顾问委员会”方法,其中 Claude 可以综合多个观点以及它自己的观点,以提供更全面的答案。

<a href="https://glama.ai/mcp/servers/@YuChenSSR/multi-ai-advisor-mcp"> <img width="380" height="200" src="https://glama.ai/mcp/servers/@YuChenSSR/multi-ai-advisor-mcp/badge" alt="Multi-Model Advisor MCP server" /> </a>

graph TD

A[开始] --> B[工作者 本地 AI 1 观点]

A --> C[工作者 本地 AI 2 观点]

A --> D[工作者 本地 AI 3 观点]

B --> E[管理者 AI]

C --> E

D --> E

E --> F[做出决定]

特性

- 使用单个问题查询多个 Ollama 模型

- 为每个模型分配不同的角色/人物角色

- 查看系统上所有可用的 Ollama 模型

- 为每个模型自定义系统提示

- 通过环境变量配置

- 与 Claude for Desktop 无缝集成

前提条件

- Node.js 16.x 或更高版本

- 已安装并运行的 Ollama(参见 Ollama 安装)

- Claude for Desktop(用于完整的咨询体验)

安装

通过 Smithery 安装

要通过 Smithery 为 Claude Desktop 自动安装 multi-ai-advisor-mcp:

npx -y @smithery/cli install @YuChenSSR/multi-ai-advisor-mcp --client claude

手动安装

-

克隆此存储库:

git clone https://github.com/YuChenSSR/multi-ai-advisor-mcp.git cd multi-ai-advisor-mcp -

安装依赖项:

npm install -

构建项目:

npm run build -

安装所需的 Ollama 模型:

ollama pull gemma3:1b ollama pull llama3.2:1b ollama pull deepseek-r1:1.5b

配置

在项目根目录中创建一个 .env 文件,其中包含您所需的配置:

# 服务器配置

SERVER_NAME=multi-model-advisor

SERVER_VERSION=1.0.0

DEBUG=true

# Ollama 配置

OLLAMA_API_URL=http://localhost:11434

DEFAULT_MODELS=gemma3:1b,llama3.2:1b,deepseek-r1:1.5b

# 每个模型的系统提示

GEMMA_SYSTEM_PROMPT=你是一个富有创造力和创新精神的 AI 助手。跳出框框思考,提供新颖的视角。

LLAMA_SYSTEM_PROMPT=你是一个支持性和同理心的 AI 助手,专注于人类福祉。提供周到且平衡的建议。

DEEPSEEK_SYSTEM_PROMPT=你是一个逻辑性和分析性的 AI 助手。逐步思考并清楚地解释你的推理。

连接到 Claude for Desktop

-

找到您的 Claude for Desktop 配置文件:

- MacOS:

~/Library/Application Support/Claude/claude_desktop_config.json - Windows:

%APPDATA%\Claude\claude_desktop_config.json

- MacOS:

-

编辑文件以添加 Multi-Model Advisor MCP 服务器:

{

"mcpServers": {

"multi-model-advisor": {

"command": "node",

"args": ["/absolute/path/to/multi-ai-advisor-mcp/build/index.js"]

}

}

}

-

将

/absolute/path/to/替换为您的项目目录的实际路径 -

重新启动 Claude for Desktop

用法

连接到 Claude for Desktop 后,您可以通过多种方式使用 Multi-Model Advisor:

列出可用模型

您可以查看系统上所有可用的模型:

Show me which Ollama models are available on my system

这将显示所有已安装的 Ollama 模型,并指示哪些模型配置为默认模型。

基本用法

只需让 Claude 使用多模型顾问:

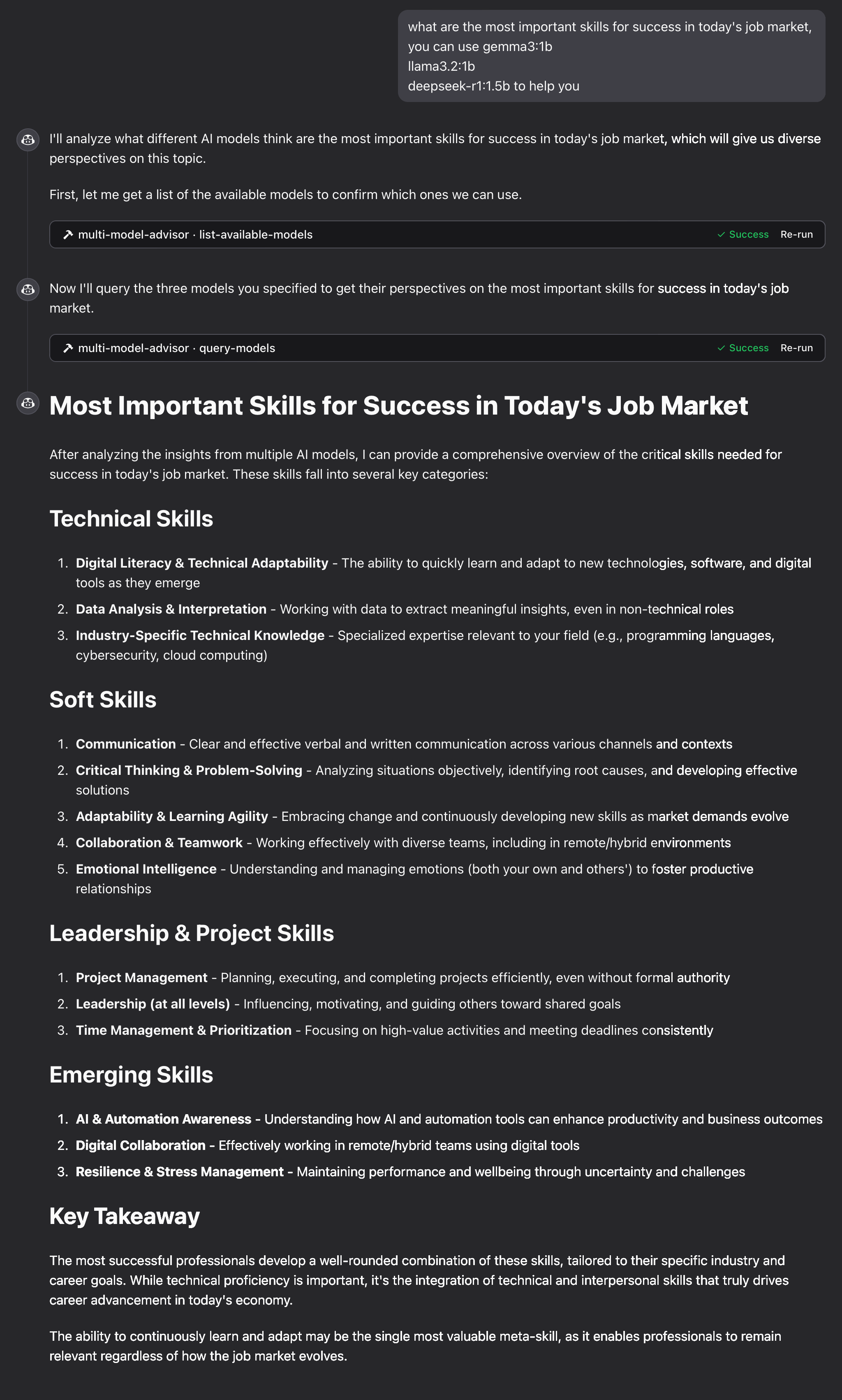

what are the most important skills for success in today's job market,

you can use gemma3:1b, llama3.2:1b, deepseek-r1:1.5b to help you

Claude 将查询所有默认模型,并根据它们的不同视角提供综合响应。

工作原理

-

MCP 服务器公开两个工具:

list-available-models:显示系统上的所有 Ollama 模型query-models:使用问题查询多个模型

-

当您向 Claude 提出一个问题,提到多模型顾问时:

- Claude 决定使用

query-models工具 - 服务器将您的问题发送到多个 Ollama 模型

- 每个模型都以其视角做出回应

- Claude 接收所有响应并综合出一个全面的答案

- Claude 决定使用

-

每个模型都可以分配不同的“角色”或角色,从而鼓励不同的视角。

故障排除

Ollama 连接问题

如果服务器无法连接到 Ollama:

- 确保 Ollama 正在运行 (

ollama serve) - 检查 .env 文件中的 OLLAMA_API_URL 是否正确

- 尝试在浏览器中访问 http://localhost:11434 以验证 Ollama 是否响应

找不到模型

如果某个模型报告为不可用:

- 检查您是否已使用

ollama pull <model-name>拉取了该模型 - 使用

ollama list验证确切的模型名称 - 使用

list-available-models工具查看所有可用模型

Claude 未显示 MCP 工具

如果这些工具未出现在 Claude 中:

- 确保在更新配置后重新启动了 Claude

- 检查 claude_desktop_config.json 中的绝对路径是否正确

- 查看 Claude 的日志以查找错误消息

内存不足

一些管理者的 AI 模型可能选择了更大的模型,但没有足够的内存来运行它们。您可以尝试指定一个较小的模型(参见基本用法)或升级内存。

许可证

MIT 许可证

有关更多详细信息,请参阅此项目存储库中的 LICENSE 文件

贡献

欢迎贡献! 请随时提交拉取请求。

推荐服务器

Crypto Price & Market Analysis MCP Server

一个模型上下文协议 (MCP) 服务器,它使用 CoinCap API 提供全面的加密货币分析。该服务器通过一个易于使用的界面提供实时价格数据、市场分析和历史趋势。 (Alternative, slightly more formal and technical translation): 一个模型上下文协议 (MCP) 服务器,利用 CoinCap API 提供全面的加密货币分析服务。该服务器通过用户友好的界面,提供实时价格数据、市场分析以及历史趋势数据。

MCP PubMed Search

用于搜索 PubMed 的服务器(PubMed 是一个免费的在线数据库,用户可以在其中搜索生物医学和生命科学文献)。 我是在 MCP 发布当天创建的,但当时正在度假。 我看到有人在您的数据库中发布了类似的服务器,但还是决定发布我的服务器。

mixpanel

连接到您的 Mixpanel 数据。 从 Mixpanel 分析查询事件、留存和漏斗数据。

Sequential Thinking MCP Server

这个服务器通过将复杂问题分解为顺序步骤来促进结构化的问题解决,支持修订,并通过完整的 MCP 集成来实现多条解决方案路径。

Nefino MCP Server

为大型语言模型提供访问德国可再生能源项目新闻和信息的能力,允许按地点、主题(太阳能、风能、氢能)和日期范围进行筛选。

Vectorize

将 MCP 服务器向量化以实现高级检索、私有深度研究、Anything-to-Markdown 文件提取和文本分块。

Mathematica Documentation MCP server

一个服务器,通过 FastMCP 提供对 Mathematica 文档的访问,使用户能够从 Wolfram Mathematica 检索函数文档和列出软件包符号。

kb-mcp-server

一个 MCP 服务器,旨在实现便携性、本地化、简易性和便利性,以支持对 txtai “all in one” 嵌入数据库进行基于语义/图的检索。任何 tar.gz 格式的 txtai 嵌入数据库都可以被加载。

Research MCP Server

这个服务器用作 MCP 服务器,与 Notion 交互以检索和创建调查数据,并与 Claude Desktop Client 集成以进行和审查调查。

Cryo MCP Server

一个API服务器,实现了模型补全协议(MCP),用于Cryo区块链数据提取,允许用户通过任何兼容MCP的客户端查询以太坊区块链数据。